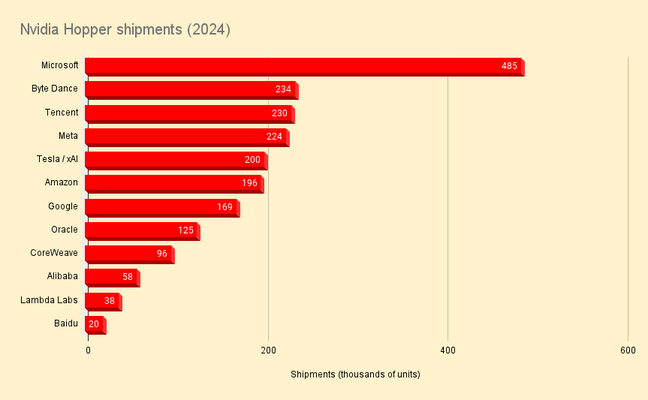

A Nvidia dominou a área de IA em 2024, com as remessas de suas GPUs Hopper mais do que triplicando, para mais de dois milhões entre seus 12 maiores clientes, de acordo com estimativas da Omdia.

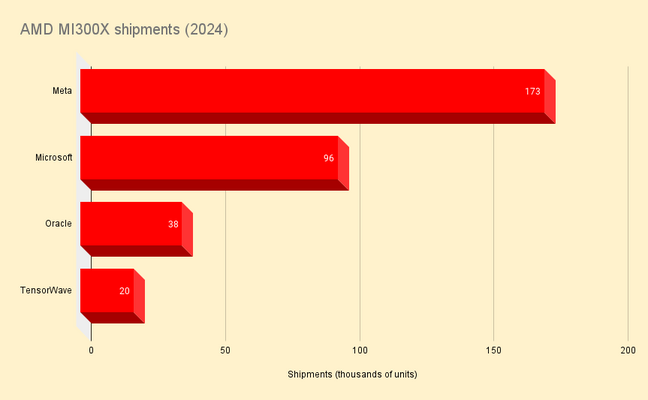

Mas embora a Nvidia continue sendo um titã da infraestrutura de IA, ela enfrenta uma concorrência mais acirrada do que nunca da rival AMD. Entre os primeiros usuários de suas GPUs da série Instinct MI300, a AMD está rapidamente ganhando participação.

A Omdia estima que a Microsoft comprou aproximadamente 581.000 GPUs em 2024, o maior número de qualquer cliente de nuvem ou hiperescala no mundo. Destes, um em cada seis foi construído pela AMD.

Na Meta – de longe a adotante mais entusiasmada dos aceleradores com apenas um ano de idade, de acordo com as descobertas da Omdia – a AMD foi responsável por 43 por cento das remessas de GPU, com 173.000, contra 224.000 da Nvidia. Enquanto isso, na Oracle, a AMD foi responsável por 23% das 163.000 remessas de GPU da gigante de bancos de dados.

A Nvidia continuou sendo o fornecedor dominante de hardware de IA em 2024. Crédito: Omdia – clique para ampliar

Apesar da crescente participação entre clientes importantes como Microsoft e Meta, a participação da AMD no mercado mais amplo de GPU permanece comparativamente pequena ao lado da Nvidia.

As estimativas da Omdia rastrearam remessas de MI300X em quatro fornecedores – Microsoft, Meta, Oracle e GPU bit barn TensorWave – que totalizaram 327.000.

As remessas de MI300X da AMD permaneceram uma fração das da Nvidia em 2024. Crédito: Omdia – clique para ampliar

A ascensão da AMD não é menos notável, já que seus aceleradores da série MI300 estão no mercado há apenas um ano. Antes disso, as GPUs da AMD eram usadas predominantemente em aplicativos de computação de alto desempenho mais tradicionais, como o supercomputador 1.35 exaFLOPS Frontier do Oak Ridge National Laboratory (ORNL).

“Eles conseguiram provar a eficácia das GPUs no cenário de HPC no ano passado e acho que isso ajudou”, disse Vladimir Galabov, diretor de pesquisa para nuvem e datacenter da Omdia. O Registro. “Acho que havia sede de uma alternativa da Nvidia.”

Por que AMD?

É difícil dizer até que ponto essa sede é impulsionada pelo fornecimento limitado de hardware Nvidia, mas pelo menos no papel, os aceleradores MI300X da AMD ofereceram uma série de vantagens. Introduzido há um ano, o MI300X reivindicou desempenho de ponto flutuante 1,3x maior para cargas de trabalho de IA, bem como largura de banda de memória 60% maior e capacidade 2,4x maior do que o venerável H100.

Os dois últimos pontos tornam a peça particularmente atraente para cargas de trabalho de inferência, cujo desempenho é mais frequentemente ditado pela quantidade e velocidade da sua memória, em vez de quantos FLOPS a GPU pode gerar.

De modo geral, a maioria dos modelos de IA atuais são treinados com precisão de 16 bits, o que significa que, para executá-los, são necessários aproximadamente 2 GB de vRAM para cada bilhão de parâmetros. Com 192 GB de HBM3 por GPU, um único servidor possui 1,5 TB de vRAM. Isso significa que modelos grandes, como o modelo de fronteira Llama 3.1 405B da Meta, podem ser executados em um único nó. Por outro lado, um nó H100 equipado de forma semelhante não possui a memória necessária para executar o modelo em resolução total. O H200 de 141 GB não sofre dessa mesma limitação, mas a capacidade não é o único truque de festa do MI300X.

O MI300X possui 5,3 TBps de largura de banda de memória, contra 3,3 TBps no H100 e 4,8 TBps no H200 de 141 GB. Juntos, isso significa que o MI300X deveria, em teoria, ser capaz de atender modelos maiores mais rapidamente do que as GPUs Hopper da Nvidia.

Mesmo com o Blackwell da Nvidia, que está apenas começando a chegar aos clientes, avançando em desempenho e largura de banda de memória, o novo MI325X da AMD ainda mantém uma vantagem de capacidade de 256 GB por GPU. Seu MI355X mais poderoso, com lançamento previsto para o final do próximo ano, aumentará para 288 GB.

Como tal, não é nenhuma surpresa que a Microsoft e a Meta, que estão implementando grandes modelos de fronteira medindo centenas de bilhões ou até trilhões de parâmetros em tamanho, tenham gravitado em torno dos aceleradores da AMD.

Isto, observa Galabov, refletiu-se na orientação da AMD, que tem subido consistentemente trimestre após trimestre. A partir do terceiro trimestre, a AMD agora espera que o Instinct gere US$ 5 bilhões em receitas no ano fiscal de 2024.

Indo para o Ano Novo, Galabov acredita que a AMD tem a oportunidade de ganhar ainda mais participação. “A AMD executa bem. Ela se comunica bem com os clientes e é boa em falar sobre seus pontos fortes e fracos de forma transparente”, disse ele.

Um fator potencial é o surgimento de celeiros de bits de GPU, como o CoreWeave, que implantam dezenas de milhares de aceleradores por ano. “Alguns deles tentarão propositalmente construir um modelo de negócios em torno de uma alternativa da Nvidia”, disse Galabov, apontando o TensorWave como um exemplo.

Silício personalizado atinge seu ritmo

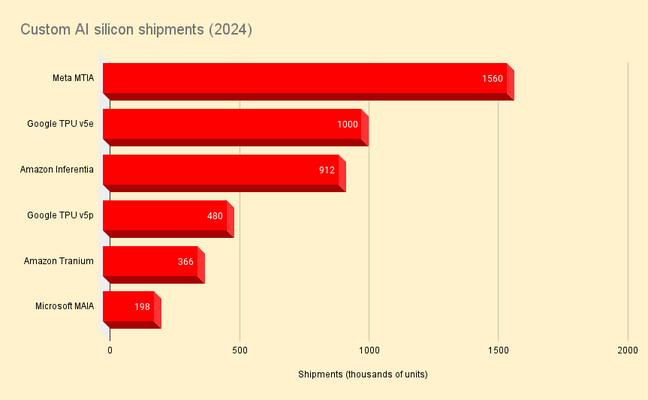

Não é apenas a AMD que está destruindo o império da Nvidia. Ao mesmo tempo em que a nuvem e os hiperescaladores estão comprando grandes quantidades de GPUs, muitos estão implantando seus próprios silício de IA personalizados.

Os provedores de nuvem implantaram grandes quantidades de silício de IA personalizado em 2024, mas é importante lembrar que nem todas essas partes foram projetadas para GenAI. Crédito Omdia – clique para ampliar

A Omdia estima que as remessas de aceleradores MTIA personalizados da Meta, que analisamos com mais detalhes no início deste ano, atingiram 1,5 milhão em 2024, enquanto a Amazon fez pedidos de 900.000 chips Inferentia.

Se isso representa ou não um desafio para a Nvidia depende muito da carga de trabalho. Isso ocorre porque essas partes são projetadas para executar tarefas mais tradicionais de aprendizado de máquina, como os sistemas de recomendação usados para combinar anúncios com usuários e produtos com compradores.

Embora Inferentia e MTIA possam não ter sido projetados com LLMs em mente, as TPUs do Google certamente foram e têm sido usadas para treinar muitos dos modelos de linguagem do gigante das buscas, incluindo seus modelos proprietários Gemini e abertos Gemma.

O melhor que Omdia pode imaginar é que o Google fez pedidos de cerca de um milhão de aceleradores TPU v5e e 480.000 aceleradores TPU v5p este ano.

Além do Inferentia, a AWS também possui seus chips Trainium, que apesar do nome foram reajustados para cargas de trabalho de treinamento e inferência. Em 2024, a Omdia calcula que a Amazon encomendou cerca de 366.000 dessas peças. Isso está alinhado com seus planos para o Projeto Rainier, que fornecerá ao construtor de modelos Anthropic “centenas de milhares” de seus aceleradores Trainium2 em 2025.

Finalmente, há as peças MAIA da Microsoft, que foram apresentadas pela primeira vez pouco antes da AMD lançar o MI300X. Semelhante ao Trainium, essas partes são ajustadas tanto para inferência quanto para treinamento, algo que a Microsoft obviamente faz bastante como principal parceiro de hardware da OpenAI e construtora de modelos por direito próprio. Omdia acredita que a Microsoft encomendou cerca de 198.000 dessas peças em 2024.

O mercado de IA é maior que o hardware

Os ganhos monumentais de receita da Nvidia nos últimos dois anos, compreensivelmente, destacaram a infraestrutura por trás da IA, mas é apenas uma peça de um quebra-cabeça muito maior.

Omdia espera que a Nvidia tenha dificuldades no próximo ano para aumentar sua participação no mercado de servidores de IA, à medida que AMD, Intel e os provedores de serviços em nuvem promovem hardware e serviços alternativos.

“Se aprendemos alguma coisa com a Intel, depois de atingir mais de 90% de participação, é impossível continuar a crescer. As pessoas procurarão imediatamente uma alternativa”, disse Galabov.

No entanto, em vez de lutar por participação num mercado cada vez mais competitivo, Galabov suspeita que a Nvidia se concentrará na expansão do mercado total endereçável, tornando a tecnologia mais acessível.

A introdução dos microsserviços de inferência da Nvidia (NIMs), modelos em contêineres projetados para funcionar como peças de um quebra-cabeça para a construção de sistemas complexos de IA, são apenas um exemplo desse pivô.

“É a estratégia de Steve Jobs. O que tornou o smartphone um sucesso foi a App Store. Porque ela torna a tecnologia fácil de consumir”, disse Galabov sobre os NIMs. “É o mesmo com a IA; crie uma loja de aplicativos e as pessoas farão o download do aplicativo e o usarão.”

Dito isto, a Nvidia continua baseada no hardware. Provedores de nuvem, hiperescaladores e celeiros de GPU já estão anunciando clusters massivos baseados nos novos e poderosos aceleradores Blackwell da Nvidia, que estão bem à frente de tudo o que a AMD ou a Intel têm a oferecer hoje, pelo menos em termos de desempenho.

Enquanto isso, a Nvidia acelerou seu roteiro de produtos para suportar uma cadência anual de novos chips para manter sua liderança. Parece que embora a Nvidia continue a enfrentar forte concorrência de seus rivais, não corre risco de perder sua coroa tão cedo. ®